L'influence de l'intelligence artificielle dans l'automobile

- Dans la conception, l’ingénieur ne “dessine” plus vraiment seul

- L’IA ne génère plus des pièces, elle génère des architectures complètes

- La simulation prédictive réduit massivement les prototypes physiques

- Les supercalculateurs deviennent des plateformes que l’IA orchestre

- Un tri automatique entre mécanique, électronique, software et thermique

- L’optimisation orientée coût est devenue une étape native

- La documentation technique se génère presque toute seule

- Le design extérieur et intérieur bénéficie d’une génération massive de variantes

- Giga-casting et optimisation topologique : un duo parfaitement adapté à l’IA

- Une réduction massive des cycles de développement

- Dans la fabrication, l’usine devient un organisme qui s’auto-corrige

- Robots, IA embarquée et usines qui n’ont plus grand-chose de manuel

- La qualité contrôlée par vision IA

- L’IA comme chef d’orchestre de la logistique interne

- La maintenance prédictive pour éviter les catastrophes silencieuses

- Le rôle grandissant des humanoïdes industriels

- La fabrication réactive grâce à l’analyse en continu

- Les véhicules qui se déplacent seuls dans l’usine

- Une fabrication plus rapide, plus propre et moins chère

- Crash-tests et sécurité

- Conduite assistée et autopilot : du supercalculateur embarqué

- Le réseau de perception : transformer le monde réel en données utilisables

- La fusion des capteurs : reconstruire une scène cohérente en temps réel

- Les calculateurs embarqués : des monstres de calcul dédiés au temps réel

- Les réseaux neuronaux : apprendre à conduire comme un humain, mais sans pause

- L’entraînement sur supercalculateurs : des milliards de km simulés chaque semaine

- La planification de trajectoire : décider en quelques millisecondes

- Les limites actuelles : bruit, imprévus et comportements humains

- Ce que l’avenir proche prépare : plus de capteurs, plus de puissance et plus de données

- Les chatbots embarqués : du gadget bavard au copilote numérique

- Gestion de flotte : l’optimisation à grande échelle

- Assurance : la tarification devient comportementale

- Une industrie qui accélère plus vite que ses propres voitures

.jpg)

L’IA n’est plus un champ d’expérimentation dans l’automobile. C’est devenu un levier opérationnel, un multiplicateur de productivité et un outil de pilotage qui s’immisce partout. On la retrouve dans la conception des pièces, dans l’ingénierie logicielle embarquée, dans les usines, dans les crash-tests, dans les calculateurs des systèmes ADAS, dans la gestion des flottes et jusque dans les bureaux des assureurs qui rêvent de tarifer les conducteurs à la calorie d’énergie nerveuse près. On voit apparaître un changement d’ère, quelque chose de structurant, pas un gadget destiné à faire vendre trois équipements optionnels.

Dans la conception, l’ingénieur ne “dessine” plus vraiment seul

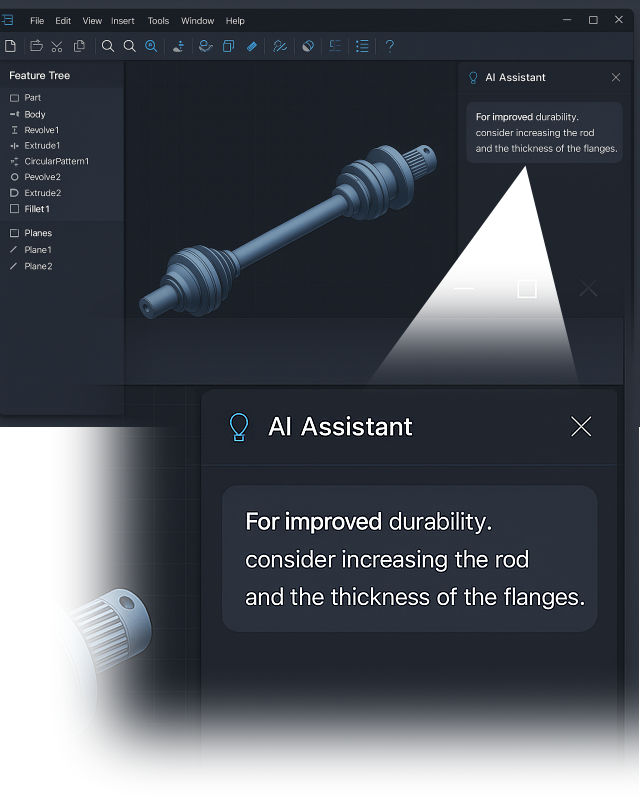

Les bureaux d’étude ne ressemblent plus à ce qu’ils étaient il y a dix ans. Les logiciels de CAO comme CATIA, Siemens NX, Creo ou Autodesk Fusion 360 ne se limitent plus à être des planches à dessin numériques. Ils deviennent des environnements de développement assistés par IA. Un ingénieur modélise une pièce et l’outil intervient immédiatement : il détecte les zones faibles, propose des variantes, ajuste les formes, vérifie la compatibilité avec les contraintes d’encombrement et pond des versions allégées adaptées aux efforts.

L'IA réduit les cycles d’itérations, élimine les propositions incohérentes, classe les résultats, rapproche les configurations qui ont le plus de chances d’être valables. Elle utilise aussi l’historique du constructeur : les pannes connues, les pièces qui ont posé problème, les géométries qui vieillissent mal. Générer dix variantes d’une même pièce prenait autrefois une journée ; cela se fait désormais en quelques minutes.

L’IA s’invite aussi directement dans les outils de travail des ingénieurs, là où on ne l’attendait pas forcément. Les interfaces de développement intègrent maintenant de vrais assistants techniques capables de générer du code, de proposer des correctifs, d’anticiper des conflits entre modules, ou de réécrire en quelques secondes une fonction que quelqu’un aurait mis deux heures à épurer à la main. Sur des logiciels comme Catia, Matlab/Simulink, Altium ou même les IDE internes des constructeurs, ces assistants suggèrent des variantes de modèles 3D, testent automatiquement des configurations et repèrent les incohérences entre les contraintes mécaniques et électroniques. Concrètement, ça revient à avoir un collègue hyperactif qui ne dort jamais et qui te mâche en permanence 30 à 50 % du boulot répétitif. Résultat : les équipes produisent plus vite, avec moins d’erreurs, et les cycles de développement se raccourcissent sans que personne ait besoin de rallonger ses journées.

L’IA ne génère plus des pièces, elle génère des architectures complètes

Les outils actuels ne se limitent plus à optimiser une pièce isolée. Ils sont capables de proposer des architectures de véhicules entiers : disposition moteur, organisation d’un pack batterie, géométrie de longerons, maillage des traverses, choix des points d’ancrage, répartition globale des masses et premiers schémas électriques. Les modèles génératifs travaillent à l’échelle système, en intégrant simultanément les contraintes d’encombrement, de rigidité, de dissipation thermique, de conformité réglementaire et de facilité d’assemblage. Là où plusieurs semaines de discussions, de croquis et de simulations étaient nécessaires, quelques heures suffisent désormais pour produire une série de concepts cohérents et exploitables.

La simulation prédictive réduit massivement les prototypes physiques

Bien avant les simulations par éléments finis classiques, l’IA analyse chaque géométrie pour prévoir son comportement dans le temps. Les défauts de vieillissement, les déformations en cycles thermiques, les zones de fatigue ou les accumulations de contraintes apparaissent immédiatement. Cette pré-analyse permet d’éliminer les architectures bancales avant même qu’un premier calcul détaillé soit lancé. Grâce à ce filtrage, plusieurs constructeurs observent une baisse de 20 à 30 % des prototypes physiques, car les erreurs structurelles majeures sont détectées dès la phase conceptuelle.

Les supercalculateurs deviennent des plateformes que l’IA orchestre

Les clusters HPC utilisés par les constructeurs avalent chaque jour des milliers de simulations thermiques, mécaniques et aérodynamiques. Leur intérêt réel ne vient plus seulement de leur puissance brute, mais du rôle de l’IA qui pilote leur fonctionnement. Les modèles choisissent quelles simulations lancer, éliminent celles qui n’ont aucun intérêt, regroupent celles qui se recoupent et classent les résultats en fonction de leur pertinence. Les ingénieurs ne se retrouvent plus noyés sous des quantités absurdes de données : seules les configurations critiques ou prometteuses remontent à l’analyse humaine.

Un tri automatique entre mécanique, électronique, software et thermique

La complexité des véhicules modernes implique une interdépendance permanente entre les disciplines. Une forme mécanique influence un échauffement, un faisceau modifie une géométrie, une stratégie logicielle impose un renfort structurel, et une contrainte réglementaire bloque un choix de matériau. L’IA croise en continu ces paramètres. Elle détecte un faisceau trop proche d’une zone chaude, une antenne perturbée par une pièce métallique, un capteur mal orienté ou un élément trop long à usiner en grande série. Une conception valide sur le plan mécanique peut ainsi être rejetée pour des raisons de coût, de disponibilité matière ou d’impossibilité d’assemblage industriel.

L’optimisation orientée coût est devenue une étape native

Lorsqu’une pièce est esquissée, les outils évaluent immédiatement le prix matière, la difficulté d’extrusion, le temps d’usinage, le taux probable de rebuts et le coût d’outillage. Une géométrie performante mais trop chère est éliminée sans délai. Cette approche, désormais généralisée, permet de réduire de 5 à 12 % le coût de certaines familles de composants, simplement en éliminant en amont des choix industriels sous-optimaux.

La documentation technique se génère presque toute seule

Les tâches les plus chronophages des bureaux d’étude, nomenclatures, arbres fonctionnels, fiches d’assemblage, cahiers fournisseurs, rapports de validation, notes PCR, sont désormais produites automatiquement. Les outils récupèrent la géométrie, les contraintes, les matériaux et les résultats de simulations, et génèrent des documents complets en quelques minutes. Ce remplacement d’un travail répétitif par un processus automatisé libère une quantité considérable de temps d’ingénierie.

Le design extérieur et intérieur bénéficie d’une génération massive de variantes

L’IA est devenue un outil quotidien dans les studios de design. Elle propose des centaines de variations de lignes, de volumes, de signatures lumineuses ou de surfaces intérieures, tout en évaluant leur faisabilité industrielle, leur impact aérodynamique et leur conformité réglementaire. Les designers ne partent plus d’une feuille blanche mais d’un ensemble riche de directions visuelles pré-filtrées. Ce processus accélère la naissance de thèmes forts tout en limitant les impasses stylistiques coûteuses.

Giga-casting et optimisation topologique : un duo parfaitement adapté à l’IA

La fabrication d’éléments structurels géants en une seule pièce impose une optimisation extrême des nervures, zones d’absorption et chemins de charge. Les modèles IA sont aujourd’hui au cœur de cette étape, car ils génèrent des centaines de variantes structurales avant de converger vers une géométrie à la fois rigide, légère, industrialisable et compatible avec les contraintes de coulée. Tesla, XPeng ou Volvo exploitent déjà ce couple IA + giga-casting pour réduire massivement le nombre de pièces, de points de soudure et de sources de tolérances cumulées.

Une réduction massive des cycles de développement

L’accumulation de ces outils modifie profondément le rythme industriel. Les constructeurs observent des cycles de développement raccourcis de 20 à 40 %, des équipes resserrées, une baisse du nombre de prototypes physiques, et des erreurs tardives largement moins fréquentes. Les projets gagnent en cohérence dès les premières itérations, car les incohérences majeures sont éliminées immédiatement, sans avoir besoin d’attendre la construction d’un premier prototype.

Dans la fabrication, l’usine devient un organisme qui s’auto-corrige

Sur les lignes de production, l’intelligence artificielle se retrouve dans chaque recoin. Les caméras de vision industrielle équipées de réseaux neuronaux inspectent les pièces mieux que n’importe quel opérateur. Une peinture trop granuleuse, un défaut de moulage, une soudure qui manque légèrement de pénétration ou un écart d’alignement sur un panneau : tout est repéré instantanément, même quand l’œil humain ne capterait rien. L’intérêt est simple : les retouches diminuent, les rebuts aussi, et la chaîne maintient une qualité beaucoup plus stable.

Robots, IA embarquée et usines qui n’ont plus grand-chose de manuel

La fabrication automobile n’a plus rien de linéaire. Chaque poste de l’usine tourne maintenant autour d’un noyau logiciel qui anticipe, ajuste et corrige en continu. L’IA surveille les chaînes comme un contremaître hyperactif : cadence des robots, dérive des outils, usure des pinces, micro-écarts dans les tolérances, tout est analysé en direct. Les dérives qui auparavant étaient repérées après plusieurs heures d’arrêt ou de rebut sont maintenant détectées en quelques secondes. Résultat : moins de défauts, moins de pertes et des arrêts de ligne réduits au strict minimum.

La qualité contrôlée par vision IA

Les caméras haute résolution, maintenant dopées à des modèles de reconnaissance d’image spécialisés, repèrent la moindre irrégularité : micro-rayures, défaut de peinture, variation d’épaisseur de cordon de colle, alignement des ouvrants ou défaut d’assemblage. Là où des équipes inspectaient manuellement en fin de ligne, l’IA contrôle chaque véhicule en temps réel. Les constructeurs parlent d’une réduction de 30 à 50 % des défauts détectés trop tard pour être corrigés sans démonter la voiture.

L’IA comme chef d’orchestre de la logistique interne

La logistique interne a basculé dans une gestion totalement dynamique. Les algorithmes ajustent la livraison des pièces selon les retards fournisseurs, les aléas de production et les temps d’usinage réels. Un poste ralentit, et c’est tout le flux des AGV (robots convoyeurs autonomes) qui se réorganise dans les minutes suivantes. Les écarts entre la théorie et ce qui se passe réellement sur la ligne sont absorbés automatiquement, évitant des pénuries ponctuelles ou des surstocks coûteux.

La maintenance prédictive pour éviter les catastrophes silencieuses

Les machines-outils sont bardées de capteurs et d’historiques de fonctionnement. L’IA analyse les vibrations, les températures, les pressions, le bruit, l’évolution des cycles, et prévient avant la panne. Ce n’est pas un gadget : certaines usines annoncent des baisses de 20 à 40 % des arrêts non planifiés. Les robots sont entretenus juste avant que leur performance ne chute, jamais après.

Le rôle grandissant des humanoïdes industriels

Certaines tâches, trop variables pour des robots rigides, reviennent progressivement à des humanoïdes industriels dotés d’un modèle IA dédié. Ils manipulent des pièces non standardisées, s’adaptent aux écarts légers de position, corrigent des gestes non répétitifs et peuvent même apprendre de simples instructions humaines. Ce n’est pas de la science-fiction : plusieurs usines asiatiques commencent à utiliser ces robots comme “main flexible” pour les opérations où le robot classique ne fait pas l’affaire.

La fabrication réactive grâce à l’analyse en continu

Le couplage machine learning + jumeau numérique permet de simuler l’impact d’un changement de cadence, d’un changement d’alliage ou d’un nouveau fournisseur avant de toucher la chaîne réelle. Le système prédit la stabilité de la ligne, le risque de saturation, le taux de rebut, et propose les ajustements nécessaires sans passer par une longue phase d’essais. C’est un changement radical dans la manière de prendre des décisions industrielles.

Les véhicules qui se déplacent seuls dans l’usine

Dans certaines usines, les voitures se déplacent d’un poste à l’autre sans conducteur, avec une précision quasi chirurgicale. Tesla l’utilise depuis plusieurs années, mais d’autres s’y mettent. Les véhicules roulent à vitesse lente, suivent leur itinéraire par vision, communiquent entre eux et s’adaptent à la circulation interne. Plus besoin de personnel pour les manœuvrer. C’est un gain de temps et un moyen de limiter les erreurs humaines dans des ateliers où l’espace est réduit et la cadence élevée.

Une fabrication plus rapide, plus propre et moins chère

En combinant logistique dynamique, contrôle qualité automatisé, maintenance prédictive et véhicules autonomes internes, les usines abaissent significativement leurs coûts d’exploitation. Certaines lignes gagnent 10 à 20 % de cadence supplémentaire sans embauche, simplement parce que les pertes et les micro-arrêts disparaissent. Les retouches baissent, les opérations inutiles disparaissent, et les chaînes deviennent capables d’absorber plus facilement les variations de modèles et de configurations.

Crash-tests et sécurité

L’apport réel de l’IA dans la sécurité automobile ne se trouve pas dans la multiplication des crash-tests virtuels. Les logiciels capables de simuler une collision existent depuis des années, et ils n’ont jamais besoin d’un apprentissage automatique pour faire tourner leurs modèles physiques. Ce que l’IA change réellement, c’est le travail préparatoire, celui qui intervient avant même qu’une première simulation ne soit lancée.

Les modèles analysent la géométrie des pièces, les jonctions, les zones d’absorption, les chemins de charge et comparent tout cela avec les historiques d’accidents et de défaillances réelles. Les faiblesses structurelles, les concentrations de contraintes et les zones qui vieillissent mal apparaissent très tôt, souvent dès les premières itérations de conception.

L’IA analyse les historiques d’accidents, les défauts récurrents, les zones de rupture observées dans les précédentes générations, les variations de comportement selon les alliages, les traitements thermiques et les géométries utilisées. Elle croise ça avec les résultats d’essais réels, les mesures de déformation à haute vitesse et même les données télémétriques issues de la route. À partir de là, elle est capable de proposer directement des géométries plus robustes, d’anticiper un point de faiblesse, de détecter une zone où la rigidité locale ne suit pas le reste de la structure, ou de prévoir l’impact d’un changement de matériau avant même qu’un ingénieur ne commence à modéliser.

Autre apport concret : les assistants IA intégrés aux logiciels comme LS-DYNA, Abaqus ou même Catia analysent les plans au fur et à mesure de leur conception. Ils signalent les incohérences, les zones trop rigides ou trop souples, les cavités problématiques, les jonctions mal alignées, bref toutes les sources potentielles de défaillance qui autrefois n’étaient détectées qu’après plusieurs prototypes physiques. Résultat : moins de prototypes, moins de corrections tardives et une architecture plus stable dès les premières itérations.

L’intérêt, c’est la vitesse. Là où une équipe mettait une semaine à faire tourner plusieurs simulations et analyser les résultats à la main, un modèle IA pré-traite, classe, compare avec les historiques et remonte directement les cas suspects. Pas de magie : la physique reste la même, les règles de crash sont les mêmes, mais tout ce qui est chronophage et pénible est désormais automatisé. Les ingénieurs, eux, peuvent se concentrer sur les arbitrages cruciaux plutôt que sur le tri manuel des dizaines de gigaoctets de données.

Conduite assistée et autopilot : du supercalculateur embarqué

Les véhicules modernes fonctionnent avec des quantités délirantes de données. Les calculateurs de type Tesla Hardware 4 ou Nvidia Drive Orin atteignent plusieurs centaines de TOPS (Tera Operations Per Second), ce qui revient à installer un supercalculateur compact derrière le tableau de bord. Ces systèmes avalent les flux caméra, les radars et les données de capteurs divers pour reconstruire en temps réel une scène cohérente : un piéton hésitant, un cycliste qui se décale, un camion mal centré, un marquage effacé, un panneau déformé, un véhicule arrêté en plein virage.

Le réseau de perception : transformer le monde réel en données utilisables

La conduite assistée moderne repose d’abord sur la perception. Une voiture ne peut rien anticiper sans transformer ce qu’elle voit en données interprétables. Les systèmes actuels s’appuient principalement sur des caméras haute résolution, parfois combinées à des radars ou lidars selon les constructeurs. Le flux arrive dans un pipeline qui analyse la lumière, les contours, les lignes, les volumes, les mouvements, et convertit tout cela en une représentation compréhensible pour un réseau neuronal. Ce n’est pas un simple traitement d’image : c’est un découpage complet du monde en voitures, piétons, bordures, signalisation, ombres, rails, bords de route, flaques, débris ou cyclistes en mouvement.

La difficulté vient du fait que tout cela doit se faire en continu, à chaque milliseconde, sans jamais accumuler de retard. Une seule latence excessive peut provoquer un sous-virage, un freinage trop tardif ou une mauvaise anticipation d’un piéton qui traverse.

La fusion des capteurs : reconstruire une scène cohérente en temps réel

Même si la tendance actuelle va vers le “vision-only”, beaucoup de constructeurs utilisent encore un ensemble de capteurs hétérogènes. L’IA doit fusionner ces flux pour obtenir une scène complète et stable : le radar fournit les vitesses relatives, la caméra les formes et les couleurs, le lidar, quand il est présent, donne une carte 3D précise.

La fusion doit éliminer les contradictions, compenser les angles morts, corriger les illusions optiques et rendre cohérentes des sources qui n’ont rien en commun. Le résultat est un espace virtuel où chaque objet possède une position, une vitesse, une accélération et une intention probable. Les réseaux modernes sont capables d’anticiper la trajectoire d’un cycliste sur plusieurs secondes ou de reconnaître une voiture masquée partiellement par un camion, simplement à partir de sa silhouette résiduelle et de son mouvement.

Les calculateurs embarqués : des monstres de calcul dédiés au temps réel

L’autopilot moderne dépend entièrement de la puissance embarquée. Les calculateurs comme Tesla Hardware 4, Nvidia Drive Orin ou Mobileye EyeQ6 exécutent des centaines de milliards d’opérations par seconde. Les valeurs dépassent largement la centaine de TOPS pour traiter les caméras, les réseaux de perception, les modules de planification et les stratégies de trajectoire.

Chaque décision doit être recalculée en continu, à raison de plusieurs dizaines de fois par seconde, en tenant compte des objets détectés, de la dynamique du véhicule, de l’état de la chaussée et des règles de sécurité. La moindre baisse de puissance ou d’optimisation ferait s’effondrer le système.

Dans certaines architectures, plusieurs puces fonctionnent en parallèle pour assurer une redondance complète : si un processeur tombe, un autre prend le relais instantanément.

Les réseaux neuronaux : apprendre à conduire comme un humain, mais sans pause

La conduite autonome repose sur des réseaux neuronaux entraînés sur des millions de séquences réelles. Chaque freinage, chaque virage, chaque obstacle devient un exemple que le modèle assimile. L’objectif n’est pas de coder des règles, mais de laisser le système apprendre à reconnaître des situations et à choisir les actions les plus sûres avec la meilleure continuité.

Ces réseaux ne stockent pas des images, mais des abstractions. Ils apprennent la forme d’un trottoir, la logique d’un passage piéton, l’intention probable d’un piéton qui se penche en avant ou d’un véhicule qui “hésite” à s’insérer. Ils repèrent les micro-signes : un véhicule qui se décale légèrement dans sa voie, un piéton qui tourne la tête, un vélo qui change d’angle, une voiture garée qui semble sur le point de repartir.

L’humain a l’habitude de traiter ces signaux de manière intuitive. Le réseau neuronal les traite statistiquement, mais à une échelle qu’aucun conducteur ne pourra jamais approcher.

L’entraînement sur supercalculateurs : des milliards de km simulés chaque semaine

L’apprentissage ne se fait plus uniquement sur route. Les systèmes comme Tesla Dojo, les clusters européens ou les clouds spécialisés chinois entraînent les réseaux sur des quantités colossales de données. Des milliards d’images, des exabytes de vidéos et des millions de scénarios simulés s’accumulent en permanence.

Un réseau neuronal complet peut absorber l’équivalent de plusieurs millions de kilomètres par semaine en s’entraînant sur des variations d’infrastructures, d’éclairages, de conditions météo, de comportements humains et d’erreurs possibles. Le but est de pousser le modèle dans des situations extrêmes qu’il ne rencontrera peut-être jamais sur route réelle.

Dans certaines phases, l’apprentissage se concentre sur les incidents : freinages trop tardifs, interprétations ambiguës, hésitations ou trajectoires instables. Le système réapprend ensuite pour corriger ces comportements.

La planification de trajectoire : décider en quelques millisecondes

Une fois la scène perçue et analysée, le système doit prévoir où aller, avec quelle vitesse, quel angle de braquage et quelle marge de sécurité. La planification évalue plusieurs trajectoires possibles, simule leur issue et retient celle qui maximise la stabilité et minimise le risque.

Le processus doit tenir compte des autres usagers, de leur vitesse, de leur intention probable, de la géométrie de la route, de l’adhérence, de la météo et de la dynamique du propre véhicule.

Le calcul doit être instantané : une mauvaise anticipation peut coûter une seconde de réaction. Une seconde suffit pour transformer un scénario banal en situation dangereuse.

Les limites actuelles : bruit, imprévus et comportements humains

Malgré les progrès, certaines situations restent difficiles : conditions météo extrêmes, signalisation vieillissante, marquages effacés, comportements humains irréguliers, objets non classifiables ou ambiguïtés visuelles comme les reflets et les ombres denses.

L’autopilot doit décider même lorsque l’information est incomplète, ce qui implique toujours une part de risque. Les réseaux neuronaux n’ont pas d’intuition, seulement des probabilités. Les systèmes doivent donc intégrer plusieurs couches de sécurité : limites de vitesse dynamiques, freinage d’urgence, désactivation automatique en cas d’incertitude, et supervision humaine permanente pour certaines fonctions.

Ce que l’avenir proche prépare : plus de capteurs, plus de puissance et plus de données

Les prochaines générations de calculateurs dépasseront les 1000 TOPS, permettant de traiter davantage de caméras et des flux à plus haute résolution. Les jeux de données augmenteront encore, renforçant la capacité du système à interpréter des situations rares ou ambiguës.

Les réseaux deviendront plus spécialisés, avec des modèles dédiés à la perception piéton, d’autres aux intersections, d’autres aux comportements dangereux, et d’autres encore à la détection de panne ou de perte d’adhérence.

La conduite autonome ne dépendra pas seulement de la puissance de calcul interne, mais aussi de la collecte massive de données réelles, de la modélisation continue des scénarios et d’une amélioration progressive des comportements du réseau neuronal.

Les chatbots embarqués : du gadget bavard au copilote numérique

L’arrivée de ChatGPT, Grok et autres modèles de langage dans les voitures marque un tournant qui n’a rien d’anodin. On n’est plus face à un simple assistant vocal qui comprend une commande sur deux ; on parle de moteurs capables d’interpréter des demandes complexes, de reformuler des itinéraires, d’expliquer des fonctions de l’auto, d’écrire un message, de planifier un trajet complet avec arrêts recharge optimisés, ou même de diagnostiquer des comportements étranges du véhicule. Le système ne se contente pas d’obéir : il discute, contextualise, mémorise et ajuste sa réponse selon la situation.

Dans certaines voitures, ces modèles sont déjà capables d’interagir directement avec l’interface : régler une consigne de clim, modifier un mode de conduite, lancer une recherche sur le manuel, ou prévenir le conducteur quand une anomalie pourrait devenir un vrai problème. Les chatbots deviennent des copilotes techniques, capables de faire le lien entre l’utilisateur et les dizaines de fonctions planquées dans l’interface.

L’autre intérêt, moins visible mais plus puissant, c’est la capacité d’adaptation continue. Un modèle embarqué peut apprendre des habitudes du conducteur, anticiper ses besoins et réduire les frictions d’usage qui rendent la conduite moderne parfois lourde. Dans les années à venir, ces systèmes ne seront plus un bonus marketing, mais un élément central de l’expérience de conduite, au même titre que l’ergonomie ou le confort.

Bref, on est passé du “assistant qui comprend rien” à un copilote numérique qui peut tenir une conversation, gérer des réglages et simplifier la rencontre entre l’humain et la machine. Et que ça plaise ou non, les voitures vont suivre ce chemin.

Gestion de flotte : l’optimisation à grande échelle

Dès qu’un parc automobile dépasse quelques dizaines de véhicules, l’IA devient un avantage évident. Elle optimise les déplacements, le planning des charges, l’affectation des véhicules et même le calendrier d’entretien. Une flotte électrique bien pilotée n’a pas besoin d’autant de véhicules qu’une flotte gérée à l’ancienne : avec une gestion intelligente, on peut réduire de 10 à 20 % la taille du parc sans perdre en capacité d’usage. L’IA calcule les moments les moins coûteux pour recharger, évite les borne saturées, détecte les véhicules qui consomment de manière anormale et anticipe les arrêts techniques avant qu’ils n’affectent l’activité.

Cette logique touche aussi les centres de livraison des constructeurs, les loueurs longue durée et les opérateurs d’autopartage. Le but n’est plus de gérer, mais d’orchestrer, ce qui change toute la structure économique derrière ces activités.

Assurance : la tarification devient comportementale

Le dernier étage du fusée, et il est loin d’être anodin, concerne les assureurs. Les véhicules modernes envoient déjà une quantité énorme de télémétrie. Les assureurs n’attendent qu’une chose : pouvoir la récupérer pour tarifer les conducteurs selon leur comportement réel. Une conduite propre, stable et prévisible coûtera moins cher qu’une conduite nerveuse bourrée de freinages violents et d’accélérations impulsives. Le profil de risque n’est plus une estimation approximative basée sur l’âge ou le code postal ; c’est une signature comportementale.

Certains pays ont déjà des assurances “pay how you drive”, où la prime évolue chaque mois selon les données collectées. C’est redoutablement efficace pour récompenser les bons conducteurs, mais cela pose des questions énormes sur la vie privée. Et une fois qu’un profil “risqué” est établi, il sera difficile d’effacer ce passif numérique.

Mais techniquement, tout est prêt. Ce qui manque, c’est surtout la permission légale de connecter ces modèles sur la donnée brute des voitures. Et vue la direction que prend le secteur, ça finira tôt ou tard par arriver.

Une industrie qui accélère plus vite que ses propres voitures

Ce qui se passe est simple : l’intelligence artificielle transforme la chaîne automobile de bout en bout. La conception devient plus rapide, la fabrication plus propre, les crash-tests plus riches, la conduite assistée plus fine, la gestion des flottes plus efficace et l’assurance plus intrusive. Les constructeurs qui prennent cette transition au sérieux auront un avantage stratégique massif. Les autres, s’ils existent encore d’ici dix ans, tenteront de rattraper un train qui roule déjà à pleine vitesse.

Ecrire un commentaire

Sondage au hasard :

Pour quelle raison PRINCIPALE achèteriez-vous une voiture électrique ?

© CopyRights Fiches-auto.fr 2026. Tous droits de reproductions réservés.

Nous contacter - Mentions légales

Fiches-auto.fr participe et est conforme à l'ensemble des Spécifications et Politiques du Transparency & Consent Framework de l'IAB Europe. Il utilise la Consent Management Platform n°92.

Vous pouvez modifier vos choix à tout moment en cliquant ici.